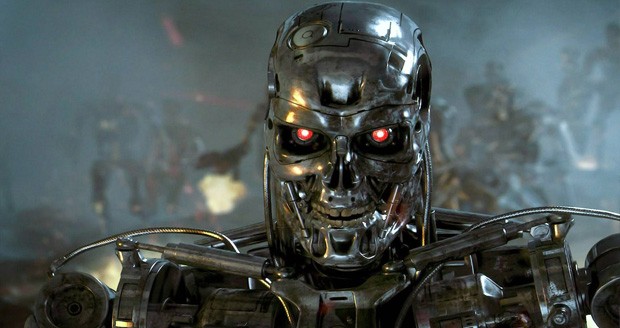

ممکن است در مورد رباتهای قاتل، رباتهای کشتار یا پایاندهندهها که رسماً به آنها سلاحهای خودمختار کشنده (LAWs) گفته میشود از فیلمها و کتابها شنیده اید. اما با پیچیدهتر شدن سلاحهای هوش مصنوعی، نگرانی در مورد ترس از عدم پاسخگویی و خطر نقص فنی این رباتها بیشتر میشود. قبلاً دیدهایم که هوش مصنوعی به اصطلاح خنثی، چگونه الگوریتمهای جنسیتگرایانه و سیستمهای تعدیل محتوای نامناسب را ایجاد کرده است که عمدتاً هم به دلیل درک نداشتن سازندگان آنها از این فناوری است. اما در جنگ، این نوع سوء تفاهم ها می تواند غیرنظامیان را بکشد یا مذاکرات را خراب کند. به عنوان مثال، یک الگوریتم تشخیص هدف می تواند برای شناسایی مخازن از تصاویر ماهوارهای آموزش داده شود. اما اگر تمام تصاویری که برای آموزش سیستم استفاده میشوند، سربازانی را در اطراف تانک نشان میدادند، چه؟ ممکن است یک وسیله نقلیه غیرنظامی که از محاصره نظامی عبور می کند را با یک هدف اشتباه بگیرد.

چرا ما به سلاح های خودمختار نیاز داریم؟

غیرنظامیان در بسیاری از کشورها (مانند ویتنام، افغانستان و یمن) به دلیل شیوه ساخت و استفاده از سلاحهای پیشرفتهتر توسط ابرقدرتهای جهانی آسیب دیدهاند. بسیاری از مردم استدلال میکنند که بیشتر ضرر کردهاند تا سود، و اخیراً به تهاجم روسیه به اوکراین در اوایل سال 2022 اشاره کردهاند. در اردوگاه دیگر افرادی هستند که می گویند یک کشور باید بتواند از خود دفاع کند، که به معنای همگام شدن با فناوری نظامی کشورهای دیگر است. هوش مصنوعی میتواند در شطرنج و پوکر از انسانها پیشی بگیرد. در دنیای واقعی نیز از انسان ها بهتر عمل می کند. به عنوان مثال مایکروسافت ادعا می کند که نرم افزار تشخیص گفتار آن دارای نرخ خطای 1٪ در مقایسه با نرخ خطای انسانی حدود 6٪ است. بنابراین تعجب آور نیست که ارتش ها به آرامی کنترل الگوریتم ها را به دست می گیرند. اما چگونه میتوانیم از اضافه کردن روباتهای قاتل به فهرست طولانی چیزهایی که آرزو میکردیم هرگز اختراع نکرده بودیم اجتناب کنیم؟

اول از همه: دشمنت را بشناس

دپارتمان دفاع ایالات متحده سیستم سلاح خودران را اینگونه تعریف میکند: «سیستم تسلیحاتی که پس از فعال شدن، میتواند بدون مداخله بیشتر توسط اپراتور انسانی، اهدافی را انتخاب کرده و درگیر کند». بسیاری از سیستم های رزمی در حال حاضر با این معیار مطابقت دارند. رایانههای روی پهپادها و موشکهای مدرن الگوریتمهایی دارند که میتوانند اهداف را شناسایی کرده و با دقت بسیار بیشتری نسبت به اپراتور انسانی به سمت آنها شلیک کنند. سلاحهای مجهز به هوش مصنوعی نیز وجود دارد که برای حمله به مردم نیز طراحی شدهاند، از رباتهای نگهبانی گرفته تا پهپادهای کامیکازه سرگردان که در جنگ اوکراین استفاده میشوند. بنابراین، اگر میخواهیم بر استفاده از قوانین تأثیر بگذاریم، باید تاریخ سلاحهای مدرن را درک کنیم.

قوانین جنگ

توافقنامههای بینالمللی، مانند کنوانسیونهای ژنو، رفتاری را برای رفتار با اسیران جنگی و غیرنظامیان در هنگام درگیری ایجاد میکنند. آنها یکی از معدود ابزارهایی هستند که ما برای کنترل نحوه جنگیدن داریم. متأسفانه، استفاده از سلاح های شیمیایی توسط ایالات متحده در ویتنام، و توسط روسیه در افغانستان، دلیلی بر عدم موفقیت این اقدامات است. مین های زمینی از سال 2015 سالانه حداقل 5000 سرباز و غیرنظامی را مجروح کرده و جان خود را از دست داده اند و در سال 2017 حدود 9440 نفر کشته شده اند. گزارش مین و مهمات خوشه ای 2022 می گوید: “تلفات… در هفت سال گذشته، به دنبال بیش از یک دهه کاهش تاریخی، به طرز نگران کننده ای بالا بوده است. سال 2021 نیز از این قاعده مستثنی نبود. این روند عمدتاً نتیجه افزایش درگیری و آلودگی توسط مین های دست ساز مشاهده شده از سال 2015 است. غیرنظامیان بیشترین کشتهها را داشتند. از بین قربانیان ثبت شده نیمی از آنها کودک بودند.” علیرغم بهترین تلاشهای ICBL، شواهدی وجود دارد که هم روسیه و هم اوکراین (عضو معاهده اتاوا) از مینهای زمینی در طول تهاجم روسیه به اوکراین استفاده میکنند. اوکراین همچنین برای هدایت حملات توپخانه ای به هواپیماهای بدون سرنشین یا اخیراً برای «حملات کامیکازه» به زیرساخت های روسیه متکی است.

آینده ما

اما سلاحهای پیشرفتهتر مجهز به هوش مصنوعی چطور است؟ کمپین توقف رباتهای قاتل نه مشکل کلیدی قوانین را فهرست میکند که بر عدم پاسخگویی و غیرانسانیسازی ذاتی کشتار ناشی از آن تمرکز دارد. در حالی که این انتقاد معتبر است، ممنوعیت کامل قوانین به دو دلیل غیر واقعی است. اول، مانند معادن، جعبه پاند همچنین خطوط بین سلاحهای خودکار، قوانین و رباتمعنای روبات های قاتل برای آینده جنگ چیست؟ ممکن است در مورد رباتهای قاتل، رباتهای کشتار یا پایاندهندهها – که رسماً به آنها سلاحهای خودمختار کشنده (LAWs) گفته میشود- از فیلمها و کتابها شنیده باشید. و ایده تسلیحات فوقهوشمند که بیداد میکنند هنوز علمی تخیلی است. اما با پیچیدهتر شدن سلاحهای هوش مصنوعی، نگرانی عمومی در مورد ترس از عدم پاسخگویی و خطر نقص فنی بیشتر میشود.

قبلاً دیدهایم که هوش مصنوعی به اصطلاح خنثی چگونه الگوریتمهای جنسیتگرایانه و سیستمهای تعدیل محتوای نامناسب را ایجاد کرده است، عمدتاً به این دلیل که سازندگان آنها این فناوری را درک نکردهاند. اما در جنگ، این نوع سوء تفاهم ها می تواند غیرنظامیان را بکشد یا مذاکرات را خراب کند. به عنوان مثال، یک الگوریتم تشخیص هدف می تواند برای شناسایی مخازن از تصاویر ماهواره ای آموزش داده شود. اما اگر تمام تصاویری که برای آموزش سیستم استفاده میشوند، سربازانی را در اطراف تانک نشان میدادند، چه؟ ممکن است یک وسیله نقلیه غیرنظامی که از محاصره نظامی عبور می کند را با یک هدف اشتباه بگیرد.

چرا ما به سلاح های خودمختار نیاز داریم؟

غیرنظامیان در بسیاری از کشورها (مانند ویتنام، افغانستان و یمن) به دلیل شیوه ساخت و استفاده از سلاحهای پیشرفتهتر توسط ابرقدرتهای جهانی آسیب دیدهاند. بسیاری از مردم استدلال میکنند که بیشتر ضرر کردهاند تا سود، و اخیراً به تهاجم روسیه به اوکراین در اوایل سال 2022 اشاره کردهاند. در اردوگاه دیگر افرادی هستند که می گویند یک کشور باید بتواند از خود دفاع کند، که به معنای همگام شدن با فناوری نظامی کشورهای دیگر است. هوش مصنوعی میتواند در شطرنج و پوکر از انسانها پیشی بگیرد. در دنیای واقعی نیز از انسان ها بهتر عمل می کند. به عنوان مثال مایکروسافت ادعا می کند که نرم افزار تشخیص گفتار آن دارای نرخ خطای 1٪ در مقایسه با نرخ خطای انسانی حدود 6٪ است. بنابراین تعجب آور نیست که ارتش ها به آرامی کنترل الگوریتم ها را به دست می گیرند. اما چگونه میتوانیم از اضافه کردن روباتهای قاتل به فهرست طولانی چیزهایی که آرزو میکردیم هرگز اختراع نکرده بودیم اجتناب کنیم؟ اول از همه: دشمنت را بشناس.

دپارتمان دفاع ایالات متحده سیستم سلاح خودران را اینگونه تعریف میکند: «سیستم تسلیحاتی که پس از فعال شدن، میتواند بدون مداخله بیشتر توسط اپراتور انسانی، اهدافی را انتخاب کرده و درگیر کند». بسیاری از سیستم های رزمی در حال حاضر با این معیار مطابقت دارند. رایانههای روی پهپادها و موشکهای مدرن الگوریتمهایی دارند که میتوانند اهداف را شناسایی کرده و با دقت بسیار بیشتری نسبت به اپراتور انسانی به سمت آنها شلیک کنند. گنبد آهنین اسرائیل یکی از چندین سامانه دفاعی فعال است که می تواند بدون نظارت انسان با اهدافی درگیر شود. در حالی که گنبد آهنین برای دفاع موشکی طراحی شده است، ممکن است به طور تصادفی افراد را بکشد. اما این خطر در سیاست بینالملل قابل قبول تلقی میشود، زیرا گنبد آهنین به طور کلی سابقه قابل اعتمادی در حفاظت از جان غیرنظامیان دارد. سلاحهای مجهز به هوش مصنوعی نیز وجود دارد که برای حمله به مردم نیز طراحی شدهاند، از رباتهای نگهبانی گرفته تا پهپادهای کامیکازه سرگردان که در جنگ اوکراین استفاده میشوند. قوانین در حال حاضر اینجا هستند. بنابراین، اگر میخواهیم بر استفاده از قوانین تأثیر بگذاریم، باید تاریخ سلاحهای مدرن را درک کنیم.

قوانین جنگ

توافقنامههای بینالمللی، مانند کنوانسیونهای ژنو، رفتاری را برای رفتار با اسیران جنگی و غیرنظامیان در هنگام درگیری ایجاد میکنند. آنها یکی از معدود ابزارهایی هستند که ما برای کنترل نحوه جنگیدن داریم. متأسفانه، استفاده از سلاح های شیمیایی توسط ایالات متحده در ویتنام، و توسط روسیه در افغانستان، دلیلی بر عدم موفقیت این اقدامات است. بدتر از آن زمانی است که بازیکنان کلیدی از ثبت نام خودداری کنند. کمپین بین المللی برای ممنوع کردن مین های زمینی (ICBL) از سال 1992 با سیاستمداران برای ممنوعیت مین ها و مهمات خوشه ای (که به طور تصادفی بمب های کوچک را در منطقه وسیعی پراکنده می کند) لابی کرده است. در سال 1997، معاهده اتاوا شامل ممنوعیت این سلاحها بود که 122 کشور آن را امضا کردند. اما آمریکا، چین و روسیه خرید نکردند.

مین های زمینی از سال 2015 سالانه حداقل 5000 سرباز و غیرنظامی را مجروح کرده و جان خود را از دست داده اند و در سال 2017 حدود 9440 نفر کشته شده اند. گزارش مین و مهمات خوشه ای 2022 می گوید: “تلفات… در هفت سال گذشته، به دنبال بیش از یک دهه کاهش تاریخی، به طرز نگران کننده ای بالا بوده است. سال 2021 نیز از این قاعده مستثنی نبود. این روند عمدتاً نتیجه افزایش درگیری و آلودگی توسط مین های دست ساز مشاهده شده از سال 2015 است. غیرنظامیان بیشترین نماینده را داشتند. از قربانیان ثبت شده که نیمی از آنها کودک بودند.” علیرغم بهترین تلاشهای ICBL، شواهدی وجود دارد که هم روسیه و هم اوکراین (عضو معاهده اتاوا) از مینهای زمینی در طول تهاجم روسیه به اوکراین استفاده میکنند. اوکراین همچنین برای هدایت حملات توپخانه ای به هواپیماهای بدون سرنشین یا اخیراً برای «حملات کامیکازه» به زیرساخت های روسیه متکی است.

آینده ما

اما سلاحهای پیشرفتهتر مجهز به هوش مصنوعی چطور؟ کمپین توقف رباتهای قاتل نه مشکل کلیدی قوانین را فهرست میکند که بر عدم پاسخگویی و غیرانسانیسازی ذاتی کشتار ناشی از آن تمرکز دارد. تقریباً مطمئناً در آینده شاهد سلاحهای بیشتری با هوش مصنوعی خواهیم بود.

ایجاد ممنوعیتهای صحیح :

جعبه سیاه هوش مصنوعی:

سیستمهایی که کاربر هیچ اطلاعاتی در مورد الگوریتم فراتر از ورودیها و خروجیها ندارد.

هوش مصنوعی غیرقابل اعتماد:

سیستمهایی که تست ضعیفی از خود نشان دادهاند

و برای داشتن دیدگاهی در مورد قوانین، لازم نیست در حوزه هوش مصنوعی متخصص باشید یا از پیشرفت های جدید هوش مصنوعی نظامی آگاه باشید. وقتی در مورد استفاده از هوش مصنوعی در جنگها می خوانید یا می شنوید، از خود بپرسید: آیا این کار موجه است؟ آیا زندگی غیرنظامیان را حفظ می کند؟ اگر نه، با جوامعی که برای کنترل این سیستمها کار میکنند، تعامل کنید.